AI, GPU Clouds, and Neoclouds in the Age of Inference

主要发现

-

AI 数据中心支出巨大,且没有放缓迹象。 可能已有超过1万亿美元被承诺用于AI数据中心的建设。

-

新型云(Neoclouds)—专为AI设计的云计算平台—正在成为数据中心行业的焦点。 其中最为突出的是CoreWeave,该公司于2025年上市,市值已超过600亿美元。

-

NVIDIA正在为新型云提供资金,且这些新型云也是NVIDIA的客户。 这种循环经济有其合法性,并且对NVIDIA有利,但其背后的泡沫问题也引发了不安的讨论。

-

替代云计算(Alternative clouds)在企业AI中展现了有前景的利基市场。 这些云计算平台的价格通常低于AWS等大型云计算平台,并提供GPU集群和企业云计算服务。特别是Vultr,这种结合方式正获得越来越多的关注。

-

对电力的需求推动了AI云的扩展。 为了满足AI容量建设的竞争,企业争先恐后地争取电力保障。

-

这一新兴市场推动了新型基础设施栈的演进,网络、存储和安全成为其中的关键要素。 每个基础设施层面都有新的需求,以支持AI云托管的规模和复杂性。

-

债务融资正在超越股权融资。 新型云的建设规模被CoreWeave等公司推动,债务主要用于购买GPU,但对于那些自建数据中心的新型云来说,债务也用于融资建设项目。

-

超大规模云计算公司(Hyperscalers)实施多元化策略以分散风险。 市场并不喜欢垄断,这种垄断不仅包括NVIDIA的GPU,还包括NVIDIA的软硬件生态。芯片和网络公司正在争取为新型云提供替代方案,超大规模云计算公司也在分散供应商风险。

1. 引言:数据中心的剧变

AI热潮已在科技与金融界掀起巨大波澜,尤其在云计算和数据中心领域表现得尤为明显。眼下,全球正掀起一场建设AI云计算的军备竞赛,这项工作需要大量的资源——土地、水源、电力——当然,还有资金。

这是GPU云和新型云(Neoclouds)的领域,它们是专门为AI训练和推理提供GPU支持的云计算平台。尽管并非所有云计算平台都在部署GPU,但由于它们规模庞大,具有极高的关注度。最为引人注目的新型云项目是耗资数十亿美元、计划消耗数吉瓦电力的巨大数据中心。

然而,即便如此,根据AI公司高层的说法,这些建设仍然远远不够。2025年,新型云的活动愈加密集,数据中心的建设计划更加宏大,资金注入也愈加庞大,债务融资也在增加。正如我们在最新一期的《云计算追踪报告》中指出的那样,未来几年超过1万亿美元的资金将会投入AI数据中心的建设。

部分资金将来自内部投资(如苹果、xAI等公司),但大部分资金,包括预计的5000亿美元的“Stargate”项目,主要用于推动AI云的繁荣,且增长速度在加快。每天似乎都有九位数的协议被宣布,意味着当本报告进入市场时,部分内容可能已过时。

这一激增还促进了与新型云相关的首次公开募股(IPO),例如CoreWeave和WhiteFiber,这些公司通过公开募股获得了资金,从而加速了建设步伐。CoreWeave预计今年将在资本支出上投入200亿至230亿美元,这一数额是其去年支出的三倍多。

其他公开上市的新型云公司也展现出类似的增长。Nebius预计2025年的资本支出为20亿美元,约为去年支出的2.5倍。Oracle预计2026财政年度(截至5月31日)的资本支出约为350亿美元,高于上年度的212亿美元;这些资金大部分将用于支持云计算的快速扩展。

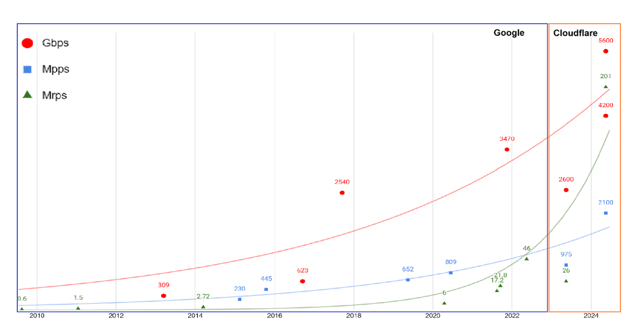

同时,超大规模公共云(hyperscalers)也加入了AI工厂建设的竞赛。如下面的图表所示,超大规模云预计将在2024年支出55%的资本支出更多。尽管有这样的预期,我们预计这些支出会有所放缓。

你可能会问:为什么数据中心的建设速度会减缓?我们只是预计,在初步激增之后,最大的云服务商可能会恢复到他们的资本支出平均水平(占收入的比例)。因为支出的增加削弱了利润率,除了Oracle最近增加了资本支出的预期,其他超大规模云商似乎也在将部分GPU云的风险外包给合作伙伴。AI的增量支出主要集中在新项目上,例如新型云和OpenAI的“Stargate”项目。

最终,新型云的业务模式本身也在变化。提供GPU集群的公司现在希望亲自管理数据中心的建设。OpenAI作为新型云的主要客户之一,也表示将开始建设自己的数据中心。“新型云”往往指代云计算服务,但现在也开始与数据中心房东这一角色相关联。

数据中心建设的规则仍在制定之中。2025年是否会成为一次异常,抑或是新常态的开始?

本报告提供了AI云、GPU云和新型云的最新动态,回顾了这一领域的历史,并分析了近期的交易和融资趋势。我们还考察了公共云中GPU相关的努力,包括超大规模云的努力。最后,我们还讨论了针对AI数据中心的基础设施生态系统,其中存储和网络技术显得尤为重要。

2. 什么是新型云?GPU 云的崛起

毫无疑问,针对AI的新型云和数据中心已经应运而生。新型云开始时主要为其他云计算提供商和企业客户提供额外的GPU计算能力。有些新型云是从其他业务转型而来的,例如加密货币挖矿或边缘计算服务。其商业模式仍在不断演变。让我们来回顾一下这一切是如何发生的。

大多数新型云最初是为加密货币挖矿者提供GPU计算能力。当这一市场放缓时,一些新型云,尤其是CoreWeave,开始将这些GPU用于AI处理。随后,OpenAI于2022年11月推出ChatGPT,启动了当前的AI热潮,并为这些GPU提供了广泛的市场需求。随之而来的是对NVIDIA芯片的抢购,导致芯片短缺,促使更多的加密货币挖矿公司转向AI。

一些规模较大的新型云并非以这种方式发展。Lambda最初是针对自动驾驶市场的。Nebius则最早作为俄罗斯搜索引擎Yandex的基础设施。自从俄罗斯入侵乌克兰后,纳斯达克宣布将Yandex从交易所退市。该公司随后将Nebius的注册地迁至荷兰,并剥离了Yandex。Nebius仍然在纳斯达克公开交易。

以下是我们对当前市场细分的看法:

-

新型云(Neoclouds):这些是专注于托管AI和高性能计算的新型云。与其他公共云不同,新型云强调GPU集群的可用性和适合AI训练和推理的性能。

-

超大规模云(Hyperscalers):GPU云服务也可以通过传统的公共云提供商,尤其是AWS等超大规模公共云获得。它们的优势在于能够更轻松地将AI工作负载与企业现有的云环境集成。然而,它们也开始像新型云一样,建设大量专门为AI设计的数据中心。

-

混合AI云(Hybrid AI clouds):这类替代云(alt clouds)提供混合型服务,包括GPU集群和传统公共云服务。它们倾向于通过服务和价格的不同来与新型云区分开来,并且通常不会建设专门用于AI的独立数据中心。

重要的新型云

许多估计认为新型云的数量大约在100个左右,但只有一小部分有可能在行业中产生重大影响。以下是我们预计将成为行业领导者的一些新兴玩家。

| 提供商 | 规模 | 芯片供应商 | 成立年份 | 总融资(包括债务) |

|---|---|---|---|---|

| Core42 | UAE拥有超过35,000个GPU,并在美国和欧洲租赁能力;约75 MW,计划短期内超过200 MW | AMD、Cerebras、NVIDIA、Qualcomm | 2023 | 超过15亿美元 |

| CoreWeave | 32个数据中心中超过250,000个GPU;超过2.2GW功率 | NVIDIA | 2017 | 在IPO前筹集超过100亿美元 |

| Crusoe | 宣称拥有946,000个GPU;约200 MW,计划最多10GW | NVIDIA、AMD | 2018 | 超过22亿美元 |

| DigitalOcean | 不明确GPU数量;全球16个数据中心;功率容量不明确 | AMD、NVIDIA | 收购Paperspace后 | 上市公司(NYSE:DOCN) |

| Fluidstack | 超过100,000个GPU;1.5GW | NVIDIA | 2017 | 450万美元,拥有高达100亿美元的债务融资 |

| Lambda Labs | 约18,000到25,000个GPU,全球14个数据中心,超过30 MW | NVIDIA | 2012 | 16.5亿美元 |

| Nebius | 超过30,000个GPU;约400 MW,计划1GW容量 | NVIDIA | 1989年成立(作为Yandex) | 上市公司(Nasdaq:NBIS),筹集约86亿美元 |

| Nscale | 50个数据中心中超过40,000个GPU;超过400 MW,计划700 MW | NVIDIA | 2024 | 17亿美元 |

| Runpod | 宣称在全球31个区域拥有“数千个GPU”;超过40 MW | NVIDIA、AMD | 2022 | 2200万美元 |

| Shakti Cloud | 超过16,000个GPU,5个数据中心,超过100 MW,计划1 GW | NVIDIA | 2024 | N/A |

| TensorWave | 约8,192个GPU,3个数据中心,计划1 GW | AMD | 2023 | 1.43亿美元 |

| TogetherAI | 超过36,000个GPU;计划达到100,000个GPU(2GW) | NVIDIA | 2022 | 5.335亿美元 |

| Voltage Park | 24,000个GPU,6个美国数据中心,超过10 MW | NVIDIA | 2023 | 5亿美元 |

| Vultr | 32个租赁数据中心,分布在6大洲;GPU和功率容量不明确 | AMD、NVIDIA | 2014 | 662百万美元 |

| WhiteFiber | 4,500多个GPU,5个数据中心;最多24 MW,计划1.3 GW | NVIDIA | 2024 | 上市公司(Nasdaq:WYFI),在IPO前筹集了未公开的资金 |

前沿AI模型撑起大笔账单,但小规模任务也同样欢迎

对于最大的新型云来说,巨大的规模更适合更复杂的应用场景:

-

AI模型:新型云最为人知的就是为所谓的前沿AI模型提供托管服务,OpenAI就是典型例子。这里包括了AI的训练和推理,尽管训练仍然是推动最大的新型云建设的主要动力。

-

增加超大规模云的容量:新型云为超大规模云提供了更快速的GPU计算能力,这些云服务商在继续部署自己的AI集群的同时,开始与新型云签署长期合同。微软已经与CoreWeave和Nebius签订了长期合同,以确保其能够满足GPU需求。

新型云当然也为企业提供服务。企业的应用场景主要包括专用模型的训练、调整和推理。下面列举了一些例子,值得注意的是,其中一些规模较小,表明新型云并非专门服务于像OpenAI这样的大型任务。

-

药物发现:制药公司SieveStack使用Nebius工具组装了一个1.5亿点的数据集,用于训练药物发现模型。数据准备管道是新型云吸引企业客户的一种方式。此外,Athos Therapeutics使用AI集群进行新的药物靶点研究,在Vultr的云中进行模型训练、微调和推理。

-

后端优化:Lablup是一家软件公司,使用Vultr作为合作伙伴。该公司开发了Backend.AI,一款AI基础设施管理平台。它通过资源管理、自动调度和MLOps管道简化了AI工作负载的部署和扩展。

一切皆关乎电力

在我们讨论向这个领域投入巨额资金之前,让我们先谈谈电力问题。

在2022年ChatGPT出现之前,高性能计算工作负载的电力密度大约为每个机架30 kW。与之相比,NVIDIA的GB200 NVL72,一个机架级系统,消耗120 kW的电力。预计到2027年底,随着Rubin Ultra芯片的到来,NVIDIA的Kyber机架架构将会包含576个GPU,并预计消耗600 kW的电力。NVIDIA推测,随着这种新架构的出现,电力、冷却和交换设施可能需要分开部署在独立的机架中。

电力合同的争夺已经成为一场游戏。这也是推动数据中心扩展的原因之一——各大公司争相确保电力供应保障。为了达成这一目标,他们必须与当地公用事业公司合作,获取电力保障,同时还需要为土地和许可的获得付出不小的努力。

尽管涉及到的电力需求极为庞大,许多新型云仍自诩为可持续发展的倡导者。这并不一定意味着它们采用可再生能源。例如,Crusoe就使用了过剩的天然气供电,这是炼油厂通常会将其燃烧掉的资源。Crusoe认为,这些能源本来不被能源公司使用,所以可以将其转变为廉价的电力来源,支持加密货币挖矿业务,同时也减少了天然气的燃烧,这为它带来了环保的形象。

然而,这依然是以碳为基础的能源选项。在欧盟和澳大利亚等地区,要求使用可再生能源。挪威因其凉爽的气候和水电资源,成为了新型云计算的热门目的地。Nscale就专注于可再生能源,且参与了OpenAI在挪威建设Stargate项目的工作。CoreWeave和Crusoe也在该地区运营数据中心。

核能是云计算提供商和数据中心运营商正在探索的另一个选项。AWS、Equinix和微软都已从核电厂采购电力。此外,一些更加独特的解决方案也在发挥作用。例如,Lambda最近宣布在加利福尼亚州山景城安装全氢能驱动的NVIDIA GB300 NVL72系统。

巨额融资,巨额债务

一些统计数据显示,新型云的数量可能超过100个,但只有一小部分会产生重要影响。它们的快速扩张需要大量的融资,其中包括债务融资。

以下是一些融资最充足的新型云的融资情况:

| 新型云公司 | 成立年份 | 股权融资 | 债务融资 |

|---|---|---|---|

| CoreWeave | 2017 | 23亿美元 | 210亿美元 |

| Crusoe | 2018 | 11.1亿美元 | 11.5亿美元 |

| Fluidstack | 2017 | 450万美元 | 100亿美元 |

| Lambda | 2012 | 9.37亿美元 | 7.75亿美元 |

| Nscale | 2024 | 13亿美元 | 无债务融资 |

| Together AI | 2022 | 5.335亿美元 | 无债务融资 |

CoreWeave的债务融资在几年之前超过了其股权融资,其他新型云也正朝着这个方向发展。这些债务用于购买GPU,但越来越多的新型云将其用于数据中心建设。通过GPU库存和长期合同作为抵押,新型云的运作可以为未来的建设项目争取更多的债务融资。

生命的循环(OpenAI 是否“大到不能倒”)

NVIDIA在维持新型云经济运转方面扮演了重要角色,它投资了CoreWeave、Lambda、Nebius和Nscale等公司。当然,这些资金中也有一部分会以芯片采购的形式流回NVIDIA。

这种循环经济虽然不舒适,但对NVIDIA来说是有利的,部分原因是这些云计算服务促进了大规模语言模型(LLM)开发商的持续增长,尤其是OpenAI,这反过来又推动了NVIDIA产品的消费。

更令人不安的是,有些公司已经变得“太大,无法倒闭”。CoreWeave预计2025年将报告超过10亿美元的净亏损,但其未来似乎依然稳固,因为NVIDIA同意购买CoreWeave所有未使用的容量,直到2032年4月,这笔协议初始价值63亿美元。

许多行业都对OpenAI产生了依赖。OpenAI签订了与Oracle的3000亿美元合同,这是“Stargate”计划的一部分,旨在通过2028年建设5000亿美元的AI基础设施。NVIDIA也在其中,最近达成了1000亿美元的投资协议,但这项交易仍未签署。所有这些都表明,整个行业对OpenAI和NVIDIA的依赖非常深重,已形成了一种相互依赖的经济模式。

区分化问题

到目前为止,新型云主要强调GPU集群的性能,并专注于迅速部署更多的GPU。提供GPU的可用性和开发速度是它们的竞争优势。

尽管这一点依然成立,但市场已经开始分化。对于最大规模的工作负载,如LLM训练,有一群已经证明能够在这种规模上运营的公司。这些公司包括CoreWeave、Crusoe、Lambda、Nebius和Nscale。

不过,随着需求的平衡,未来新型云可能需要关注企业市场的更广泛领域,而不再仅仅服务于早期的采用者。不过,在短期内,这似乎不会是一个问题,大多数新型云似乎并没有为这个未来做好准备。

某些新型云则不必过于担心区分化问题。上述提到的NVIDIA与CoreWeave的交易意味着CoreWeave可以继续建设数据中心,无需担心失败。

3. 超大规模云与GPU云策略

你可能会问:那么,云计算巨头们呢?最大的公共云也想在AI的未来中占有一席之地。它们生产了一些最大的前沿AI模型——例如微软的Copilot、亚马逊的Bedrock和谷歌的Vertex AI,这些都是来自超大规模云的AI服务,根据我们自己的《云计算追踪报告》研究,这些服务也为消费者和企业提供了众多AI服务。

这些主要的云提供商还在建设自己的AI专用数据中心,可以说是在追赶新型云的步伐。它们也将新型云作为合作伙伴,提供额外的GPU计算能力。

超大规模云与其他GPU云

以下是超大规模公共云的计划总结:

-

AWS 已启动所谓的AI区域,与沙特阿拉伯的HUMAIN和韩国的SK集团合作。位于印第安纳州的Rainier项目预计将建设多达30个AWS数据中心,总功率预计为2.2GW。AWS还提供基于NVIDIA芯片或其自家Trainium和Inferentia芯片的“超集群(UltraClusters)”。

-

微软 正在威斯康星州建设一个数据中心园区,预计2026年投入使用。但该公司也在与CoreWeave和Nebius签订长期合同,通过这些合作伙伴租赁计算能力,以确保满足自己的GPU需求。这些合同总额分别为100亿美元和194亿美元。此外,微软还与Nscale在英国的一处相对较小的设施达成了合作,计划使用50 MW和约23,000个GPU。

-

谷歌 一直在积极建设自己的AI数据中心,已在俄亥俄州、俄克拉荷马州和爱荷华/内布拉斯加州边界建设了多个数据中心,同时也宣布了阿肯色州西孟菲斯的新数据中心。尚未看到在其他国家的AI数据中心建设。

-

Oracle 提供GPU计算服务,但该公司更具挑战性和引人注目的工作是为OpenAI提供数据中心容量。Oracle在德克萨斯州Abilene的1.2GW数据中心为OpenAI提供托管服务,并且最近宣布将在德克萨斯州、新墨西哥州和一个未公开的中西部地点为OpenAI提供额外4.5GW的容量。这些计划正在顺利进行;两家公司最近签订了一项为期五年的3000亿美元协议,旨在建设更多的AI基础设施。

替代云也在采用GPU

一些替代云服务商(例如Cloudflare和Vultr)也在这一领域崭露头角。虽然其中一些公司对于被归类为新型云并不太感冒,因为它们在ChatGPT之前就已经存在,并且提供超出AI范围的云服务,但它们的初衷是成为比超大规模公共云更经济、更简单的替代品。这一战略也同样适用于它们的GPU集群。

像新型云一样,替代云也必须应对激进的GPU路线图。Vultr指出,长期的云计算操作本来就需要持续的维护——总有一些组件需要升级,且相应的预算已经拨出。它还指出,这是一项操作上的平衡艺术,而新型云还没有足够的时间掌握这一点。

作为本身是多租户的云平台,Vultr还通过虚拟化将旧设备的资源分配给多个客户来变现。而新型云似乎还没有准备好进行这种操作。到目前为止,它们还没有需要这样做的需求;一些AI客户仍在继续使用他们最初使用的GPU代际,并且将最新的GPU留给他们的新模型。

超大规模云的差异化策略

AI时代刚刚起步。推理计算和智能代理AI正在迅速发展;同时,许多企业仍处于AI的试验阶段。一些早期的采用者可能会与新型云合作,但更广泛的企业将希望将AI活动与现有云计算工作负载相融合。对于这些企业,超大规模云可以提供熟悉的环境,让他们将AI整合到整个业务工作流程中。

替代云也在争取这个市场份额。Vultr作为一个成熟的非超大规模公共云,同样迅速采用了GPU集群。Vultr以性能为吸引力,但它也通过承诺提供比超大规模云更低的价格和更简化的操作来吸引企业客户。

最后,一些企业面临着复杂的安全和合规要求。正如Vultr所指出的,那些团队希望看到来自美国注册会计师协会(AICPA)等机构的认证,或者是采用美国国家标准与技术研究院(NIST)指导方针和框架的证明。Vultr及其同行花费多年时间建立这些专业知识。尽管新型云也可以建立这些能力,但在短期内,公共云提供商应利用他们在这一领域的优势。

4. GPU云基础设施:供应商格局

我们已经讨论了大规模的数据中心建设,现在让我们更深入地探讨这些数据中心内部的组成部分。它们始于GPU,但AI推动了存储和网络领域的边界,液冷技术也迎来了它的高光时刻。

GPU:NVIDIA主导,但客户需要替代方案

NVIDIA无疑是AI超新星的核心。它的芯片主导着GPU领域,并且其激进的产品路线图推动了新型云的急速扩展。新的芯片世代预计将每年推出一次:

| 年份 | GPU架构 | FP4性能 |

|---|---|---|

| 2025 | Blackwell Ultra | 15 PFLOPs |

| 2026 | Rubin | 50 PFLOPs |

| 2027 | Rubin Ultra | 100 PFLOPs |

| 2028 | Feynmann | 待定 |

NVIDIA的这一发展轨迹正激励新型云(尤其是那些为OpenAI服务的云)迅速扩展。主流的叙事是,AI训练要求越来越密集的GPU集群,而AI推理也同样需要强大的计算能力。NVIDIA的CEO黄仁勋表示,驱动推理计算的智能代理比之前预期的消耗更多的计算资源,尤其是在推理模型和代理模型的出现之后。

由于GPU的迅速贬值,折旧问题变得非常严峻,尤其是对于新型云的数据中心来说。NVIDIA的快节奏可能会加剧这一问题,值得探讨的是,随着GPU的迭代速度加快,旧型号GPU的价值会如何保持。我们将在结论部分进一步讨论这一点。

AMD

到2025年,AMD已成为NVIDIA最主要的替代者。AMD推出了Instinct MI300系列,其旗舰产品MI355X得到了Crusoe、Oracle、TensorWave和Vultr的早期支持。

AMD相对于NVIDIA有一些优势。比如它的MI355X包含更大容量的芯片内存——288GB,相比NVIDIA的GB200的180GB。这有助于在较少的GPU上运行大型模型。TensorWave告诉我们,AMD的架构让它更容易进行虚拟化,从而同时运行多个较小的任务。这对云服务商来说是一种很好地为小型AI模型提供服务的方式。

然而,AMD不仅要与NVIDIA的高性能芯片竞争,还需要与其提供完整AI技术栈的能力竞争,包括硬件、软件、模型和开发工具。NVIDIA的优势还在于其CUDA框架支持的庞大应用基础。然而,客户和云计算平台都希望能够培养更多的替代方案,避免陷入单一供应商的生态系统。AMD进入这一领域是决心长期布局,且将会得到相当的支持。

超大规模云芯片

即使在ChatGPT时代之前,超大规模云服务商就已经开始设计自己的AI芯片。对这些云服务商来说,这代表了一个可控的、量身定制的替代方案,可以避免NVIDIA的垄断地位。

第一个出现的是谷歌的张量处理单元(TPU),自2015年以来一直在使用。阿里巴巴(Hanguang)、AWS(Inferentia和Trainium)、Meta(MTIA)和微软(Maia)也都推出了自己的AI芯片。

创业公司提供的替代方案

一些创业公司如Cerebras和Groq提供了更具颠覆性的架构。Cerebras设计了一款被称为“晶圆级”的产品,这款产品据称已经在Core42和WhiteFiber等公司使用。而Groq由前谷歌TPU团队的CEO Jonathan Ross创办,旨在设计专为AI推理优化的新芯片架构。

OpenAI也在尝试这方面的工作。2025年9月有报道称,OpenAI正在与Broadcom合作,生产专用于内部使用的AI芯片。Broadcom在此前曾与谷歌共同设计TPU。这项交易尚未确认,但媒体报道认为,这可能在2026年推出新芯片。毫无疑问,OpenAI正在计划建设自己的数据中心,并打算成为自己的云服务提供商。

网络:借鉴超大规模云的经验

在建设AI数据中心的网络架构时,最直接的方式是采用NVIDIA的技术。NVIDIA的NVLink和NVSwitch提供了GPU之间的以太网连接,连接到整个机架和数据中心。NVIDIA也是唯一提供InfiniBand的供应商,这种技术是专门为高性能计算设计的。

这种“围墙花园”式的局面为其他供应商提供了机会,前提是他们能够展示出足够的能力来取代NVIDIA。此外,随着AMD作为GPU供应商的崛起,云计算供应商正积极寻求更开放的替代方案。超以太网联盟等努力正在帮助建立标准化的方式,以强化以太网技术,满足AI工厂的需求。

客户对网络的需求不仅仅是传统的速度和带宽要求。更重要的是“从首次作业到收益的时间”,也就是“从作业开始到收到收益的时间”,正如Arista所说,新型云渴望尽早安装最新的硅芯片,因为随着GPU的迅速贬值,它们必须尽可能快地进行安装。以下是一些网络供应商在新型云市场上的策略:

-

Arista:在超大规模云数据中心取得了重大成功,尤其是在AI数据中心领域。Arista已经在多个大型AI运营商和新型云的前端和后端网络上取得了显著成绩,正在与新型云合作,定制GPU到GPU的网络设计,针对2027年推出的下一代设计。

-

思科(Cisco):思科的AI云战略以预验证的AI POD(模块化构建块)为中心,提供包括思科UCS服务器(配备NVIDIA或AMD GPU)、Nexus交换机和Hypershield安全性等解决方案。思科是Stargate UAE联盟的首选技术合作伙伴,并与HUMAIN和G42有合作伙伴关系。

-

DriveNets:DriveNets的网络云(Network Cloud-AI)提供了单一的网络堆栈,既支持GPU网络,也支持存储网络。WhiteFiber是一个曾完全使用InfiniBand的公司,现正在其位于冰岛的新数据中心中采用DriveNets的技术。

安全性:AI专用基础设施带来的新安全风险

AI专用基础设施的崛起带来了全新的网络安全风险。共享GPU、高度敏感的训练数据和分布式供应链正在扩展数据中心基础设施的攻击面。

主要的超大规模云和替代云服务商都对企业云服务的安全性需求非常熟悉,拥有数十年的安全数据、网络、计算和存储经验。但GPU云正快速实施新架构和基础设施模型,这也带来了新的安全漏洞和挑战。企业不愿将最敏感的数据交给GPU云,除非它们能确定其安全性。以下是客户在考虑使用AI专用GPU云时会关注的主要安全方面:

-

数据保障:企业正在寻求解决方案来保护数据,并确保其完整性、可靠性和安全性,因为AI正逐渐消耗更多的数据基础设施。

-

数据治理:随着AI的普及,企业需要安全地利用其数据集,并使用具有强大治理能力的AI模型。此外,它们还需要遵守全球数据主权相关的法规。

-

综合数据安全性:GPU云的激增意味着数据量的爆炸式增长。如何管理和存储这些数据?云服务提供商必须保护数据的整个生命周期——在传输过程中(跨网络)、存储时(在存储中)以及使用时(在内存中)。

-

硬件安全性:硬件级安全性正成为一个日益严重的问题,最近发现了主要供应商GPU的漏洞。新型云和GPU供应商需要制定策略来保护GPU、固件以及整个硬件和软件供应链。一些技术包括加密扫描和硬件信任根。

-

保密计算:这种方法专注于设备内存中的数据安全(数据在使用过程中)。它通过技术创建受信任的执行环境(TEE),以便私密地处理敏感信息。

-

供应链安全:GPU云必须确保整个供应链的安全,包括部署的任何软件或硬件设备,包括固件,后者正逐渐成为国家级攻击者在大规模事件中攻击的目标,例如台风攻击,这些攻击已破坏了关键基础设施。

有许多供应商正在致力于硬件安全、供应链安全和保密计算领域。这些技术可以保护数据和代码不被未经授权的使用。例如,Intel的SGX(软件保护扩展)和AMD的SEV(安全加密虚拟化)是保密计算的实际应用案例。Fortanix是这一领域的领导者,提供使用Intel SGX的运行时加密解决方案。行业领先者和公司,如Accenture、ANT集团、Arm、谷歌、华为、英特尔、Meta、微软和红帽,正与Fortanix及其他成员合作,推动保密计算的使用,并通过“保密计算联盟”共同扩大其应用。

创业公司Eclypsium则在硬件和供应链安全领域是一个值得关注的创新者。客户使用Eclypsium的平台扫描其IT基础设施中的硬件、固件和软件组件,然后标记漏洞、威胁和库存问题。该平台通过识别、验证和强化每个设备(IT、云、数据中心、网络)的第三方软件、固件和硬件,建立信任,从而保证企业基础设施的安全。

今年早些时候,Futuriom的首席分析师R. Scott Raynovich与一家大型Eclypsium客户进行了交谈,该客户正在建设AI数据中心以满足市场需求。他的看法是:

“我们的任务是提供最前沿的AI基础设施,并使其对客户可用。然而,想清楚如何从数十个供应商那里确保基础设施的安全性是疯狂的。我们希望确切知道他们的代码是否有漏洞或被篡改。如果我们的服务器固件发生变化,我们必须立即得知。”

存储:不仅仅是“存储”

VAST Data和WEKA以其基于并行文件系统的存储架构而闻名,但它们正在抓住AI时机,向市场解释它们如何超越传统的“存储”功能,提高整体数据中心效率和经济性。

VAST Data今年早些时候宣布自己是“AI操作系统”,因为它提供了一种跨越整个数据中心的架构,使得任何计算节点都可以访问任何数据。这样就消除了在许多并行作业中可能出现的瓶颈,减少了GPU在等待数据时的时间。VAST目前与所有主要的新型云合作,包括Core42、CoreWeave、Crusoe、Lambda、Nebius和Nscale。

WEKA则通过池化内存资源,使得GPU能够访问数据中心中的任何内存位置。它还提供了持久缓存等功能,确保GPU不会因缓存内存耗尽而生成冗余的令牌。WEKA着重提高推理效率,并提供减少推理时所需令牌数的技术。

DDN是高性能并行文件系统的领导者。它已经宣布Core42和Nebius为其客户,同时还表示其DDN Infinia服务是“端到端AI平台”。

OEM厂商:可以做大(机架级)

AI云建设的快速发展促进了交钥匙设备的需求。这为OEM厂商如Accton、戴尔(Dell)、惠普(HPE)和超微(Supermicro)提供了机会,它们能够将服务器、存储和网络整合成机架级解决方案。超微指出,除了速度之外,这些厂商提供的价值还在于它们作为客户和各方供应商之间的共同联系点。

液冷技术终于迎来黄金时机

冷却是GPU数据中心面临的最明显挑战。由于AI计算需求的快速增长,液冷技术迎来了它的高光时刻,但目前仍不清楚AI是否会推动云计算供应商采用液冷的异种技术。以下是当前使用的主要液冷技术:

-

单相直接芯片冷却:这种冷却方式是最简单且最广泛使用的。液体(通常是水或乙二醇)流经冷却板,吸收GPU和CPU的热量,然后继续流动,直到到达冷却分配单元(CDU),将热量排出。

-

双相冷却:与单相冷却类似,但此时液体在芯片的热量作用下被蒸发成气体。产生的热蒸气被排出机架外。这种方法仍然是一个小众选择,部分原因是它的成本较高。

-

浸没冷却:将服务器或刀片浸入液体中进行冷却。这种方式对数据中心设计的影响较大——需要一个储罐,但在大规模设置中已经得到了验证。

结论

随着GPU云市场的加速发展,金融市场、公用事业部门和AI爱好者都对这一领域充满了热情。OpenAI的CEO Sam Altman和NVIDIA的CEO Jensen Huang将他们的工作描述为加速AI创新的使命。

然而,对创新的热情也需要谨慎。新型云中的债务融资和巨额数据中心项目已经提高了这一领域的风险水平。许多交易的相互关联性使得它们依赖于少数几家公司,这引发了金融市场上的一些疑问和不安。

如果AI的收入增长未能迅速支撑这些投资,某些项目可能会被缩减或放弃。此外,新型云和GPU云仅是AI创新建设的一部分。私有AI数据中心建设、边缘AI以及其他尚未显现的AI形式也在不断发展。